Was ist eine Kolonie?

Kolonie Definition

Woher stammt der Begriff "Kolonie"? Wie lässt sich der Begriff einfach erklären? Schon bei den alten Griechen sprechen wir von "Kolonien". Der Begriff selbst stammt aus dem Lateinischen und wurde von "colere" abgeleitet, das heißt so viel wie "bebauen".

Was sind Kolonien?

Schon die Menschen der Antike kannten Kolonien. So haben die Phönizier, die ja berühmte Seefahrer waren, Kolonien an der gesamten afrikanischen Nordküste gebildet. Auch die Griechen waren in der Gründung von Tochterstädten fleißig und bildeten so genannte "Pflanzstädte" im Mittelmeerraum. Diese Kolonien waren dann von ihren Müttern, also den Stadtstaaten, von denen aus die Siedler kamen, weitgehend unabhängig.

Auch bei den Römern gab es Kolonien, also Gebiete, die von den Römern erobert wurden, meist waren dies aber Städte. Der Name der Stadt Köln wurde übrigens vom Begriff "colonia" abgeleitet, Köln war ebenso eine römische Kolonie. Doch sollte man mit dem Vergleich vorsichtig sein, denn die "Kolonie" der Antike war doch etwas anderes als die Kolonien, die später die großen Kolonialmächte im 19. Jahrhundert gegründet haben.

Warum wurden Kolonien gegründet?

Wie so oft ging es auch bei den Kolonien um wirtschaftliche Interessen. Das heißt, man versprach sich, Schätze in den verschiedenen Ländern zu gewinnen. Das traf vor allem auch auf die Kolonien in Afrika zu. Das konnten Gold, Silber oder Diamanten sein. Dazu zählten auch Bodenschätze wie Erze oder Kupfer. Exotische Handelsware war ebenfalls interessant. So gab es in vielen dieser eroberten Länder und Regionen Gewürze, Früchte, Tee, Kaffee oder Kakao - alles Dinge, die für die Europäer zunächst einmal Luxusgüter waren. In den Kolonien bekamen die Bauern allerdings meist sehr wenig Geld für ihre Erzeugnisse. Im schlimmsten Fall mussten sie als Sklaven arbeiten.

Macht, Weltgeltung und wirtschaftliche Interessen

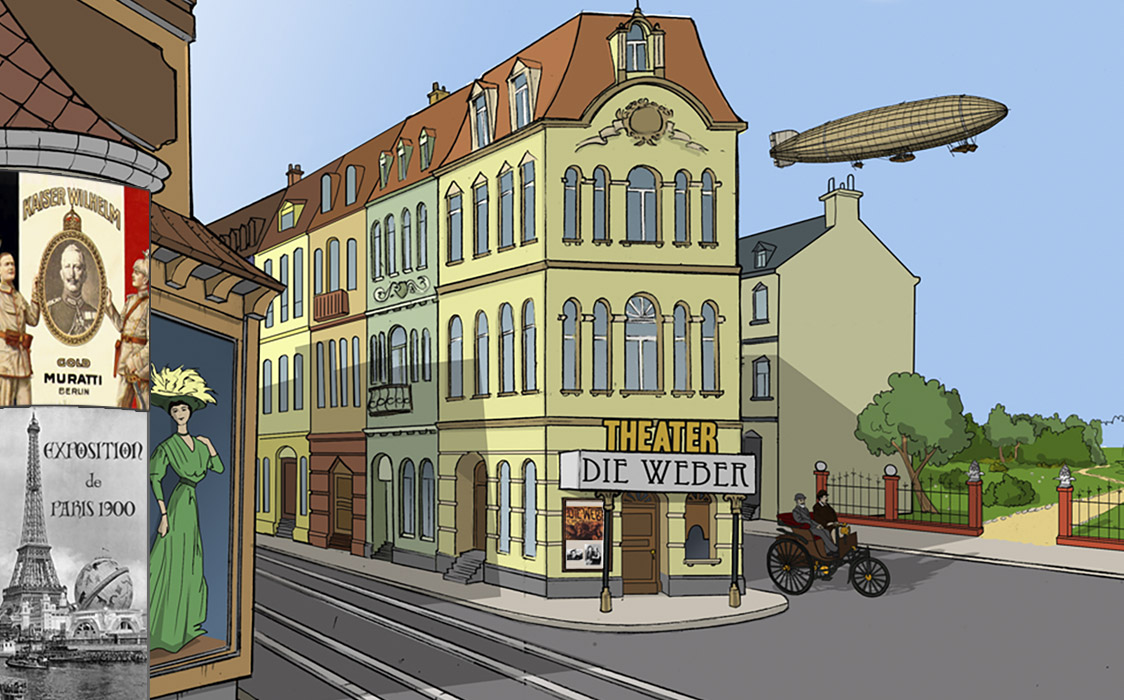

Die Kolonien sah man auch gleichzeitig als Absatzmarkt. Das heißt, man wollte europäische Güter in diese Länder verkaufen. Das funktionierte allerdings nicht immer, denn oft waren die Einwohner so arm, dass sie gar nichts kaufen konnten. Auch die Themen Macht oder Weltgeltung waren sehr wichtig. Wer mehr Länder besaß, konnte sein Ansehen als Weltmacht stärken, wurde von den anderen Ländern geschätzt und beneidet. Auch dies war ein Grund, weshalb viele Länder gerne immer mehr Kolonien in ihren Besitz bringen wollten. Das traf auch auf das Deutsche Reich zu,

Die meisten Kolonien wurden gewaltsam erobert

Doch freiwillig wollte kein Land zur Kolonie werden und sich damit in Abhängigkeit begeben. Die meisten Kolonien wurden gewaltsam erobert, manche auch ohne größeren Widerstand einfach besetzt. Fast immer versuchten die Kolonialmächte, ihre eigene Kultur, ihr Weltbild und ihr Lebensgefühl auf die Kolonien zu übertragen. Auf der anderen Seite gab es ebenso positive Entwicklungen, denn die Kolonialmächte bauten oft Schulen, Straßen und Krankenhäuser und kümmerten sich um ein funktionierendes Versorgungssystem in den Kolonien. Das war eine Verbesserung der Infrastruktur. Doch oft wurde dies auch als Rechtfertigung angeführt. Die Kolonialmächte wuschen sich rein von Schuld, indem sie betonten, wie nützlich ihr Eingreifen für die kolonalisierten Länder war.

Unterschied zwischen Kolonialismus und Imperialismus

Oft werden die Begriffe Kolonialismus und Imperialismussynonym verwendet. Das ist so nicht ganz richtig, wenn auch in der Wirklichkeit vieles sowohl auf Imperialismus wie auch Kolonialismus zutrifft. Doch die Errichter der Kolonien wollten in erster Linie wirtschaftlichen Nutzen für ihr Mutterland ziehen. Den Imperialisten ging es gleichzeitig um die Ausdehnung ihres Machtbereiches und der Errichtung eines Imperiums. Das umfasste am Ende mehr, als einige kleine Kolonien in seinen Besitz zu bringen und hat ganz viel mit der Erweiterung von Macht zu tun.

Es ist kaum vorstellbar, dass nach dem Ende des Ersten Weltkriegs noch ein Großteil der Welt in Kolonien lebte, alle Kontinente waren Teil des Kolonialismus.

Blick zurück

Kolonien gab es schon sehr lange. Es gab sie, seitdem die Europäer sich Ende des 15. Jahrhunderts auf den Weg gemacht hatten, neue Kontinente und fremde Länder zu entdecken. So waren die ersten Kolonialmächte die großen Seefahrernationen, wie Portugal, Spanien, Großbritannien, die Niederlande und Frankreich.

Staaten wie Italien, Deutschland oder Belgien wurden erst später zu Kolonialmächten. Bis zur Mitte des 19. Jahrhunderts haben sich die Europäer vor allem in Afrika zurückgehalten. Hatten sie genug mit Europa und den restlichen Kontinenten zu tun. Doch einige Regionen in Nord-, West- und Südafrika waren schon in europäischem Besitz. So rückte auch der afrikanische Kontinent in den Mittelpunkt des Interesses. Mutige Entdecker erforschten nach und nach die Geographie des Landes.

Man ging nicht nach Plan vor, sondern eroberte Gebiet für Gebiet, oft auch nach dem Zufallsprinzip. Die Franzosen hatten sich ja schon zu Napoleons Zeiten in Ägypten festgesetzt und suchten, weitere Gebiete von Nordafrika ausgehend zu erobern. Man plante, bis nach Südafrika zu gelangen und eine Schneise von Nord nach Süd in das Land zu schlagen. Italien drang in Libyen und Somalia ein und Belgien setzte sich im Kongo fest. Da wollten auch die Deutschen ein Stück vom Kuchen haben.

Blick voraus

Die meisten afrikanischen Staaten erlangten in den 1950er und 1960er Jahren ihre Unabhängigkeit. Siehe dazu: In die Unabhängigkeit.

Begriffe - kurz erklärt

Begriffe - kurz erklärt